共计 2974 个字符,预计需要花费 8 分钟才能阅读完成。

项目地址:

实验室主页:

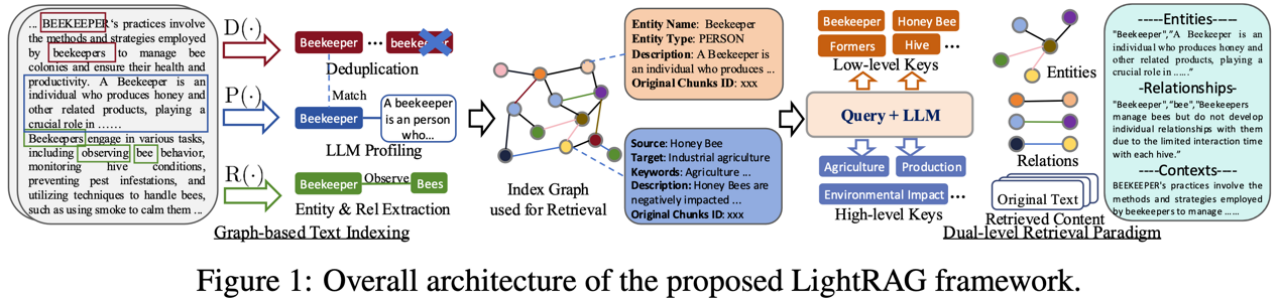

港大黄超团队最新开源的LightRAG,结合了图结构与双层检索机制,显著降低了大模型检索增强的成本,同时提升了信息检索的准确性和效率。首先,通过引入图结构,LightRAG能够更好地捕捉实体之间的复杂依赖关系,实现全面的信息理解。其次,其双层检索策略允许系统同时处理具体和抽象的查询,确保用户获得既相关又丰富的响应。此外,LightRAG具备快速适应新数据的能力,使其在动态环境中保持高效和准确。综合来看,这些优势使得LightRAG在处理复杂查询时表现出色,能够提供更具上下文相关性的答案。

1.研究背景

检索增强生成(RAG)是增强大型语言模型(LLM)性能的技术。LLM 应用广泛,但存在局限,如无法涵盖所有领域最新知识,对特定领域或复杂问题回答不够准确全面。RAG 系统通过整合外部知识源解决这些问题。它在生成回答时,结合从外部知识数据库检索的信息与 LLM 自身能力,从而提高回答的准确性、全面性以及符合用户需求的程度,增强了 LLM 在实际应用中的实用性和有效性。

现有 RAG 方法主要通过整合外部知识源来增强大型语言模型(LLM),包括检索组件获取相关文档和生成组件生成回答。然而,这些方法存在以下缺点和问题:

2.LightRAG框架

2.1 RAG框架

RAG框架可以被系统地分为两个主要部分:检索部分和生成部分。前者负责根据查询(query)返回相关的信息片段;而生成部分则由通用的生成模型,例如大语言模型,根据检索的信息和查询生成高质量回答。检索部分主要包括两大功能:

在本文中,LightRAG致力于实现几项对上述RAG系统至关重要的效率和效果指标:

2.2 基于图的文本索引

LightRAG采用了一种基于图的文本索引方法,主要包括以下几个关键方面:

实体和关系提取

基于图的文本索引的优势

快速适应增量知识库

2.3 双层检索范式

在RAG任务面临的查询请求中,主要存在以下两种类型:

为了应对这两种不同的查询请求,LightRAG设计了两种不同的检索策略:

整合图和向量进行检索

LightRAG将图结构和向量表示进行结合,从而同时满足检索的高效性和对实体间关联性的感知,具体做法如下:

– **查询关键词提取(Query Keyword Extraction)**:对于给定的查询,LightRAG的检索算法首先提取局部查询关键词和全局查询关键词。这一步骤是为了全面捕捉查询中的关键信息,以便更好地在知识图中定位相关实体和关系。

– **关键词匹配(Keyword Matching)**:算法使用高效的向量数据库来匹配局部查询关键词与候选实体,以及全局查询关键词与与全局键相关的关系。通过这种方式,能够快速定位到与查询相关的知识图元素。

– **纳入高阶相关性(Incorporating High-Order Relatedness)**:为了增强查询的高阶相关性,LightRAG进一步收集检索到的图元素在局部子图中的相邻节点。这样可以更全面地考虑与查询相关的知识图结构,提高检索结果的准确性和全面性。

双层检索范式的优势

3.实验

3.1 实验设置

评估数据集:从UltraDomain基准中选取了四个具有不同特点的数据集。Agriculture数据集包含12个文档共2,017,886个令牌,主要围绕农业实践相关主题。CS数据集有10个文档和2,306,535个令牌,侧重于计算机科学领域的多个方面。Legal数据集最大,含94个文档及5,081,069个令牌,聚焦公司法律实践。Mix数据集则包含61个文档共计619,009个令牌,涵盖多种学科的文本。这些数据集涵盖了不同领域,为全面评估模型性能提供了基础。

问题生成:将每个数据集的所有文本内容作为上下文,采用特定方法生成问题。具体是让一个大型语言模型(LLM)生成五个RAG用户以及每个用户的五个任务,对于每个用户-任务组合,LLM再生成五个需要理解整个语料库的问题,这样每个数据集最终可得到125个问题,以此来测试模型对各种问题的处理能力。

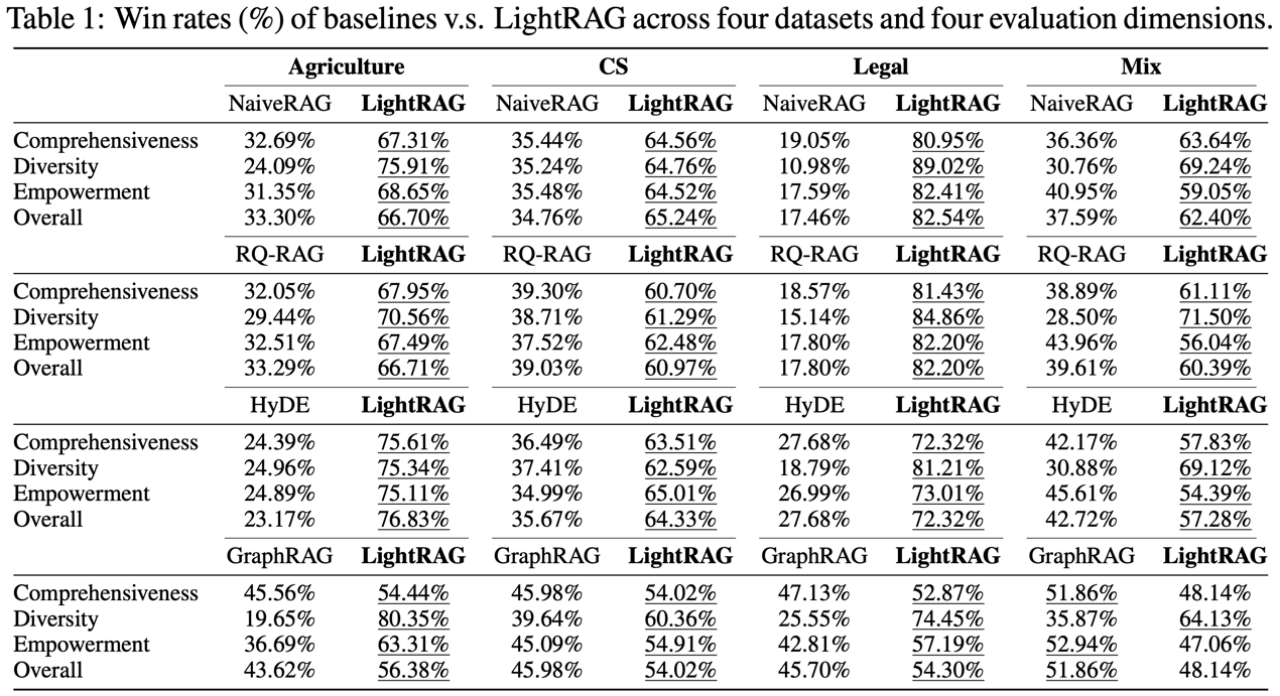

实施和评估细节:在实验中,使用nano向量数据库管理向量数据,LightRAG中基于LLM的操作默认使用GPT-4o-mini,所有数据集的块大小统一设为1200,部分参数固定。采用基于LLM的多维比较方法评估,定义了全面性、多样性、赋能性和总体四个维度。由于RAG查询标准答案难定义,利用GPT-4o-mini对基线和LightRAG排名,通过交替放置答案等方式确保公平评估并计算赢率得出结果。

3.2 基线方法对比

在不同的评估维度和四个选定的数据集(Agriculture、CS、Legal、Mix)上,将LightRAG与各种基线模型进行比较。实验结果如下图所示。在Agriculture数据集上,例如在全面性维度,Naive RAG的胜率为32.69%,LightRAG为67.31%;在多样性维度,Naive RAG为24.09%,LightRAG为75.91%等。在CS数据集、Legal数据集和Mix数据集上也呈现出类似的对比结果,LightRAG在多数评估维度上的胜率显著高于基线模型。从结果中,可以得到以下结论:

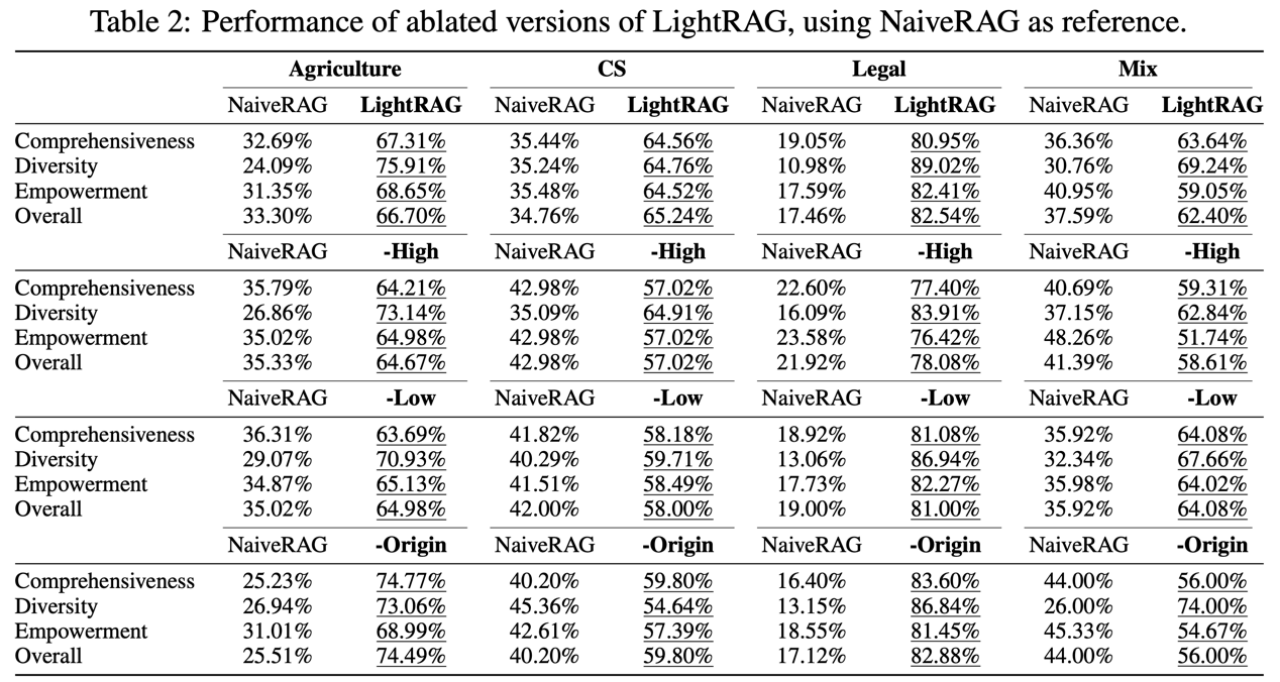

3.3 消融实验

文章还对双层检索机制,以及LightRAG中的语义图进行了消融实验,结果如下所示,从中可以观察到以下特点:

结果分析

3.4 样例学习

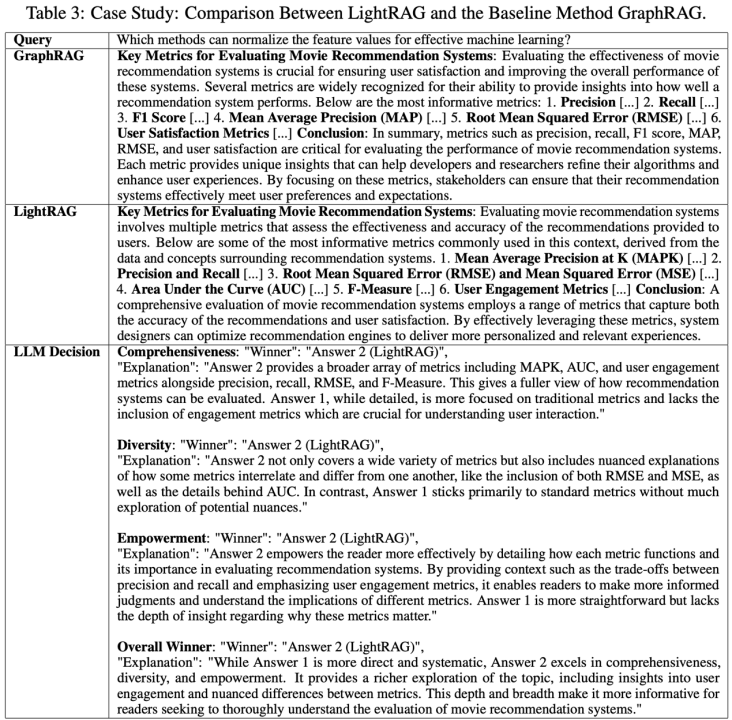

在样例学习中,文章展示了一个特定案例,比较LightRAG和GraphRAG对一个机器学习问题的回答情况。该案例聚焦于“Which methods can normalize the feature values for effective machine learning?”这一问题。两者的回答和裁定如下

在由大型语言模型(LLM)作为评判的所有评估维度上,LightRAG均优于GraphRAG。在全面性维度,LightRAG涵盖了更广泛的机器学习指标,展示出更强的发现相关信息的能力。在多样性和赋能性维度,LightRAG不仅提供了更多样的信息,还能给予读者更有价值的内容,使其能够更好地理解和应用相关知识。这些结果说明了以下问题:

3.5 模型开销和适应性分析

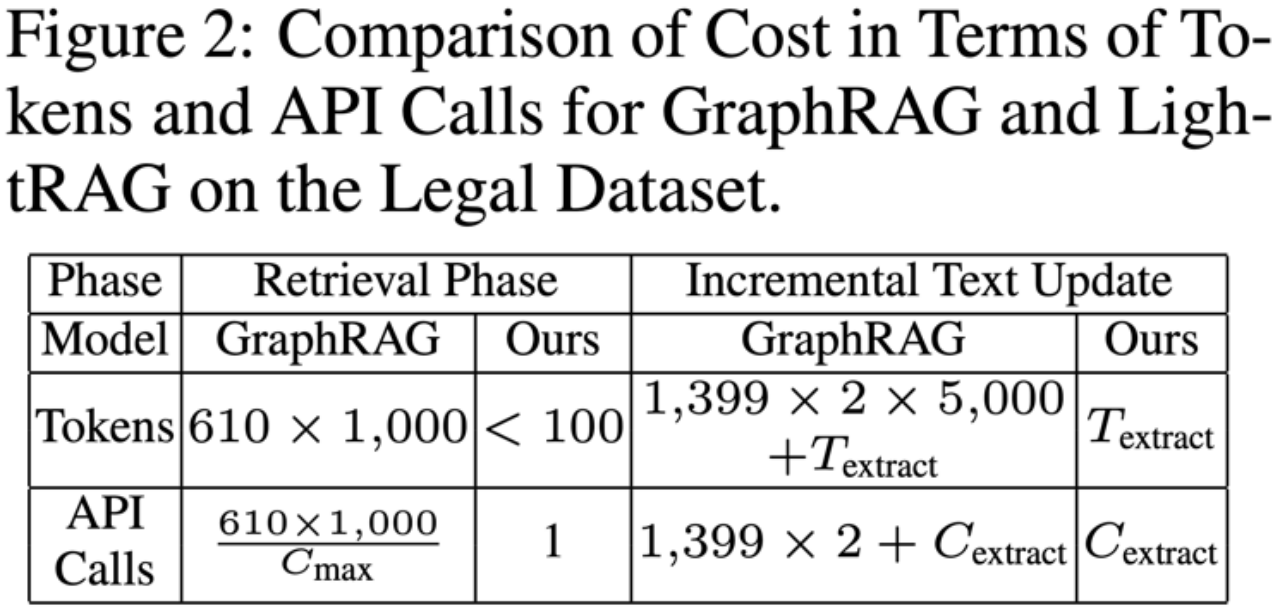

文章从两个关键角度比较LightRAG和表现最佳的基线模型GraphRAG的成本。第一个角度是检查在索引和检索过程中使用的令牌数量以及API调用次数。第二个角度是分析在动态环境中处理数据变化时这些指标的情况。实验以Legal数据集为例进行评估。

在检索阶段,LightRAG的优势在于其检索机制,它通过无缝集成图结构和向量表示进行信息检索,避免了处理大量信息的前期工作,从而大大减少了令牌使用量和API调用次数。

在增量数据更新阶段,GraphRAG由于其社区结构的处理方式,在纳入新数据时需要大量的令牌和复杂的重建过程,效率低下。而LightRAG的增量更新算法使其能够轻松集成新数据,保持系统的高效性和成本效益。

LightRAG在信息检索效率和成本效益方面表现更优。无论是在检索阶段还是在处理动态环境中的数据变化时,LightRAG都能以较低的成本提供高效的服务,其检索机制和增量更新能力使其更适合应用于实际场景中,尤其是在处理大量数据和频繁数据更新的情况下。