共计 1413 个字符,预计需要花费 4 分钟才能阅读完成。

当前,大模型研究的重点已逐步转向提升模型的推理能力。推理模型在数学、编程等领域的基准测试中已屡创突破。

那么,在需要认知策略、逻辑推演的科学研究领域,推理模型潜力如何呢?

最近,由前谷歌 CEO 埃里克・施密特(Eric Schmidt)投资的初创公司 FutureHouse,发布并开源了一个 240 亿参数的化学任务推理模型——ether0,证明了:无需额外领域预训练,通过后训练即可使推理模型具备化学领域能力,且相比领域专用模型所需数据量显著减少。

论文链接:https://storage.googleapis.com/aviary-public/ether0_preprint.pdf

模型链接:https://huggingface.co/futurehouse/ether0

科学推理模型 ether0

科学研究常涉及认知策略,如将问题分解为子问题、应对失败案例、从目标结果逆向推理等 —— 这些策略正是推理模型所展现的特性。然而,尽管科学与推理模型在概念上高度契合,目前科学推理模型的研究仍相对匮乏,主要局限于多项选择题基准测试。

要知道,评估解决方案的质量通常较为容易,而生成解决方案却很困难。例如,我们虽能精确测量特定分子的溶解度,但设计具有目标溶解度的分子却极具挑战性。

FutureHouse 致力于改变这种现状。

研究团队从学术论文中整理了化学实验数据,追踪了分子溶解度和气味等特性,并将其转化为可验证的问题。

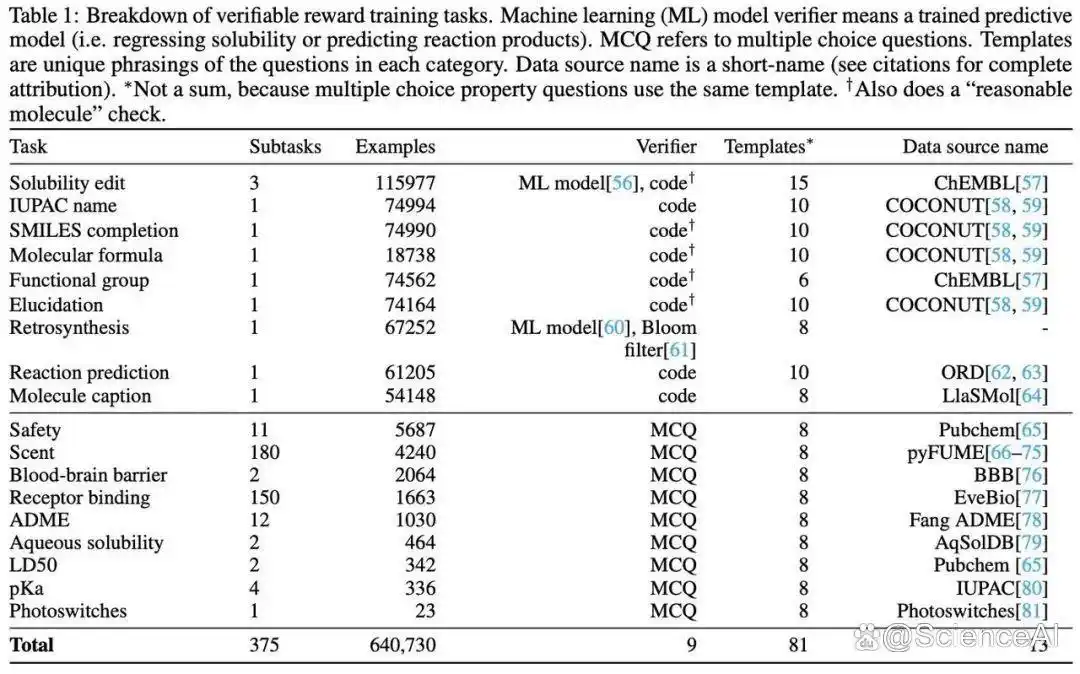

ether0 基于 Mistral-Small-24B 架构,通过强化学习进行训练,使用了 640,730 个基于实验数据的化学问题,涵盖 18 类(375 项)任务 —— 从合成可行性、血脑屏障渗透性到人体受体活性乃至气味分析。

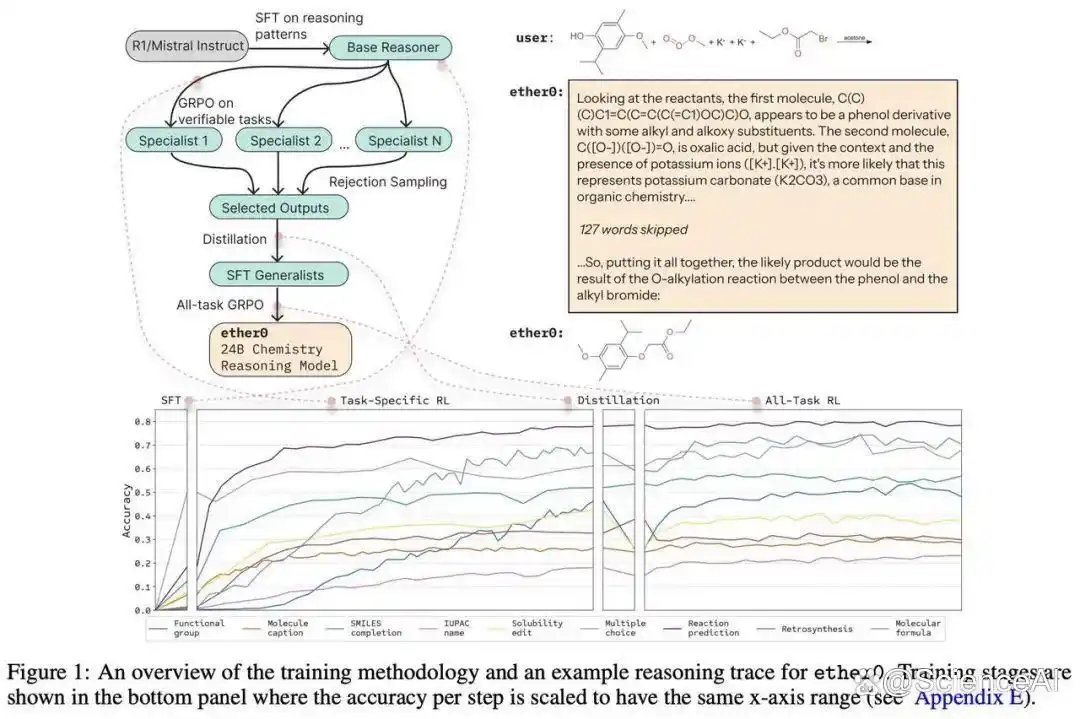

为实现高效训练,该研究采用了一系列改进方案,包括推理行为蒸馏、动态课程学习等。

下图展示了训练流程各阶段对模型多任务性能的贡献。尽管 SFT 后初始准确率普遍较低,但在特定任务强化学习阶段,所有任务性能均取得显著提升。蒸馏过程成功将专家模型的能力迁移至通用模型,全任务强化学习阶段成功修复了性能衰退,最终模型表现达到或超越对应专家模型水平。

高性能、低成本

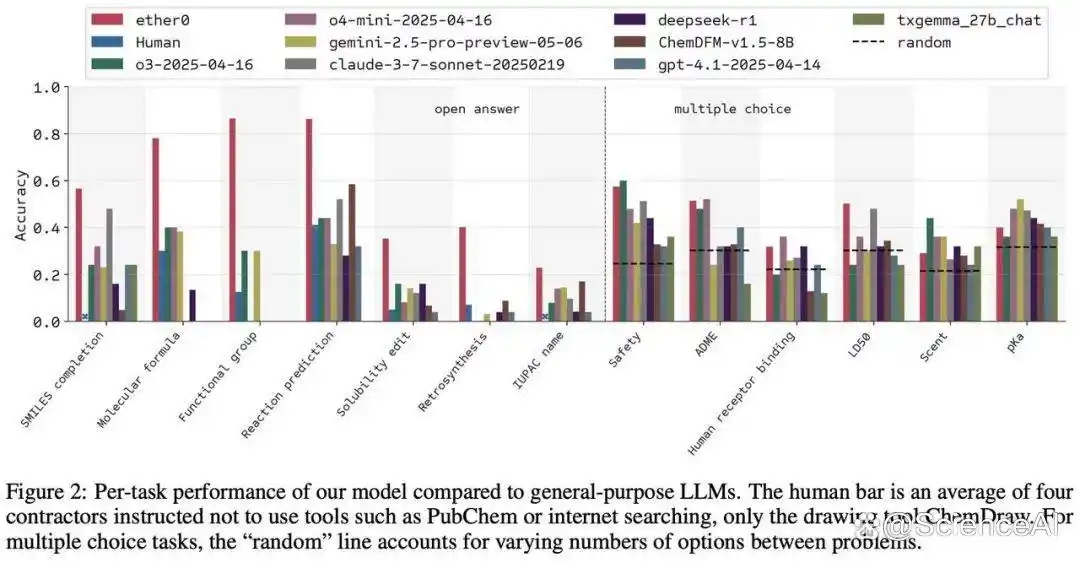

为了全面评估 ether0 的能力,研究团队将其与通用大语言模型(如 Claude、o1)和化学专用模型(ChemDFM、TxGemma)进行对比。ether0 在所有开放答案(OA)类别中准确率最高,在选择题(MCQ)方面也具备竞争力。

如下图所示,几乎在所有任务上,ether0 都超越了 GPT-4.1 和 DeepSeek-R1 等前沿模型。对于某些任务,ether0 的准确率甚至达到竞争对手的两倍以上。

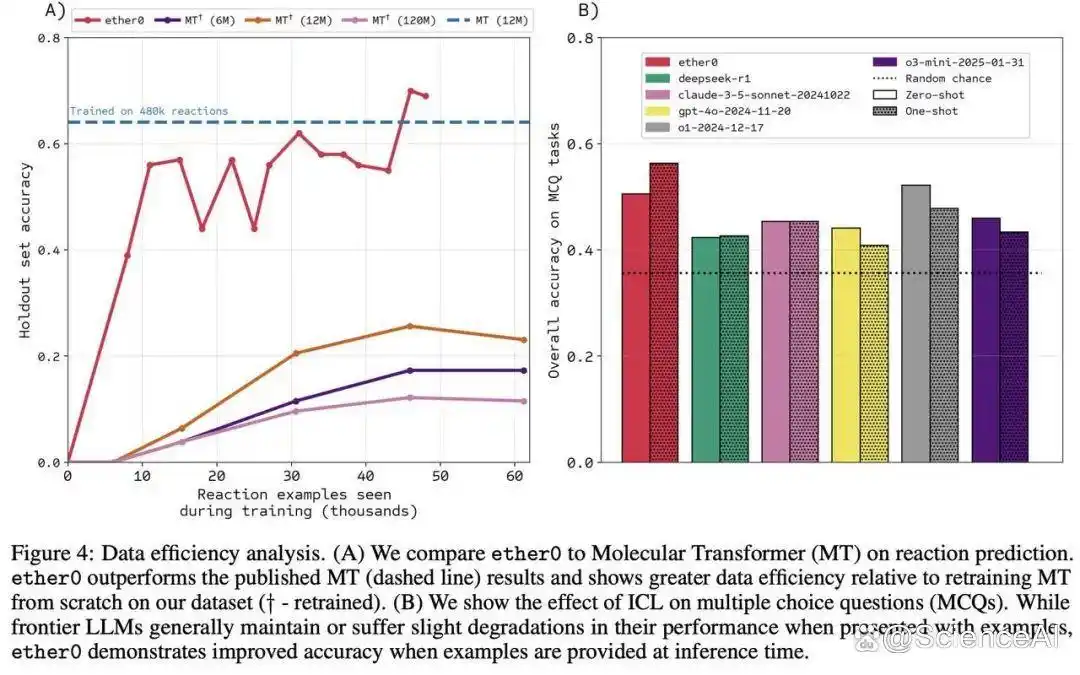

更惊人的是成本优势:要达到类似的反应预测准确率,训练一个非推理型模型需要消耗 50 倍以上的数据。

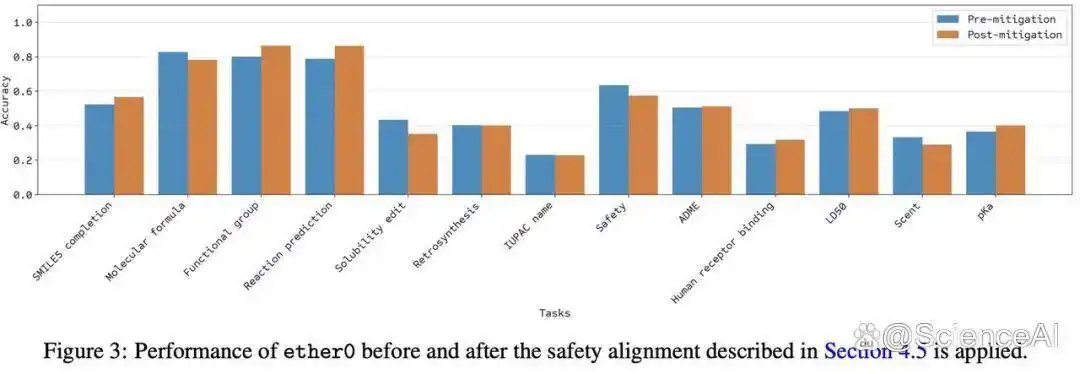

如下图所示,安全对齐流程使 ether0 拒绝 80% 的不安全提问,但未对评测任务能力产生实质影响。

由于 ether0 只能以分子式和化学反应的形式生成解决方案,因此很难在独立基准测试中与其他模型及人类表现进行交叉验证。不过,ether0 能对未经训练的分子结构进行正确推理。

总的来说,ether0 能理解自然语言提问,用自然语言进行推理,最终输出分子结构,尤其擅长类药分子设计。虽然 ether0 仍是原型产品,但研究团队已通过其获得多项重要发现,为未来构建通用科学推理模型指明了方向。